Дублированием называется наличие аналогичных страниц, которые могут быть полностью идентичными или частично схожими. В этом понятии выделяется «четкий дубль», в котором страницы имеют одинаковое содержание, но имеют разные адреса, и «нечеткие дубли», в которых также различны адреса, но информация совпадает частично.

Причинами появления таких ошибок могут быть:

-

некорректная СMS (системы, которая управляет содержимым сайта);

-

техническое несовершенство;

-

намеренное создание ошибок, если этого требует владелец сайта (к примеру, «версии для печати» и другие.

В зависимости от причины таких дублей, поисковые роботы могут полностью удалить сайт из индексации, что отрицательным образом будет сказываться на посещаемости и успешности ресурса. На такие помехи нужно своевременно адекватно реагировать, выявлять и срочным образом устранять.

Чтобы найти страницы, которые будут являться дублями, можно использовать несколько вариантов.

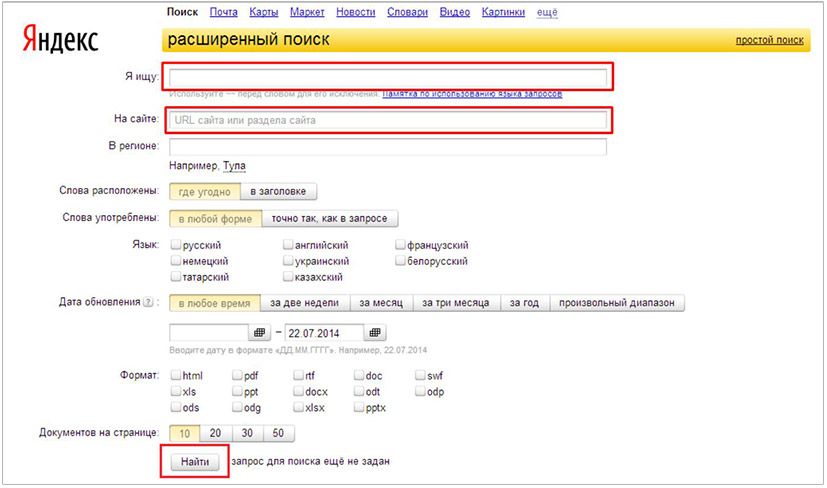

Расширенный поиск в Яндексе

В строку «я ищу» ввести текст страницы, дубли которой вы хотите найти. В следующем поле нужно ввести адрес данной страницы и воспользоваться поиском. Если поисковая система покажет вам несколько адресов, то это и будут дублированные страницы исходной.

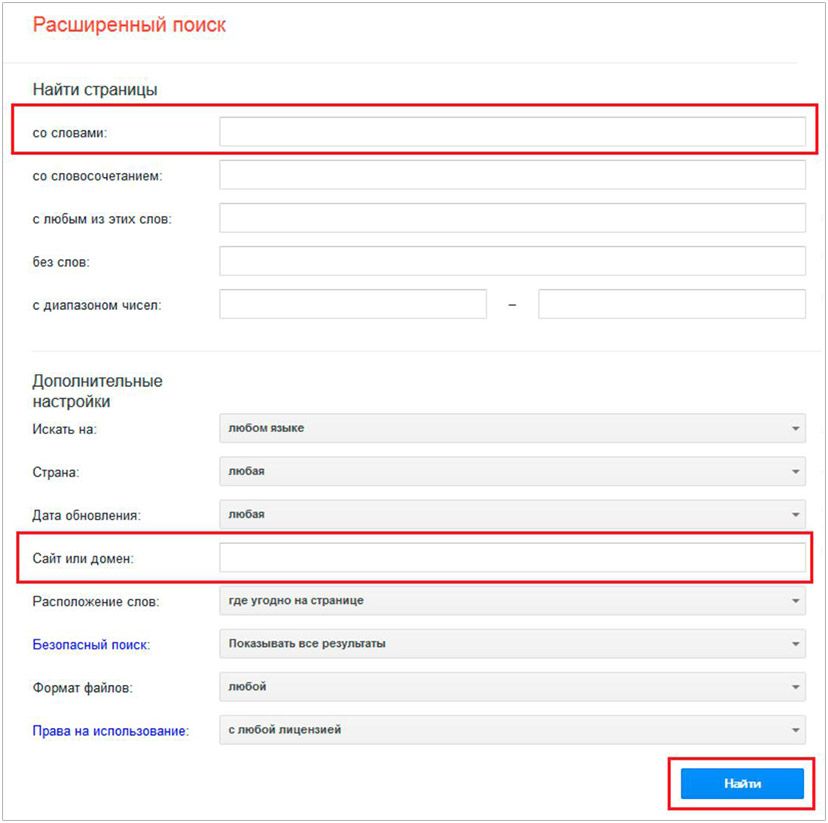

Расширенный поиск в Google

Аналогичный инструмент поиска предлагает и вторая популярная поисковая система Google:

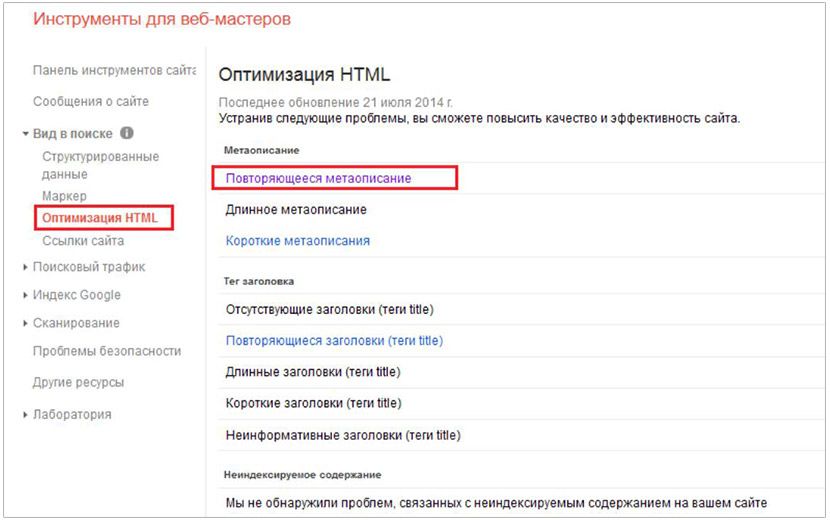

Специальные сервисы

Также существует специализированный сервис, который называется «инструменты для веб-мастеров», там нужно открыть вкладку оптимизации НТМL, она расположена в разделе вида в поиске. Там вам нужно будет выбрать поиск по совпадающим мета тегам, в результате чего вы увидите страницы, которые полностью или частично повторяют titlе, dеscription, kеywords.

Доработки

После нахождения проблем вам будет нужно устранить неполадки и доработать ресурс. Для этого можно воспользоваться несколькими вариантами решения проблемы:

-

на всех страницах дублей можно прописать noindex/nofollow, благодаря чему они не будут индексироваться;

-

в корневом каталоге ресурса находим файл rоbоts.txt и добавляем команду Disаllow, где можно указать разрешенное дублирование, то есть страницы, принадлежащие вашему сайту.